「サードパーティ・リスク管理 ~レジリエンス体制の構築と高度化~」企業がレジリエンスを高めるための適切なリスク管理とは? <2023年10月31日開催>

2023年11月28日

ノルウェー首相の訪問を記念して東京大学先端科学技術研究センターで開催されたワークショップにFRONTEOから研究開発責任者 久光 徹が登壇しました

2023年12月21日昨今、あらゆる分野において“生成AI”というフレーズが広まっています。その代表例が、対話を通じて自然な文章を自動的に作成してくれるOpenAI社の「ChatGPT」。同様の生成AIはMicrosoftやGoogleなどの大手テック企業も実用化を進めており、実際の業務に活用する企業や個人も増えています。しかしながら利便性を享受する一方で、生成AIの基本的な仕組みや抱えている課題は意外なほど知られていません。私たちはこの画期的なテクノロジーをどのようにハンドリングすべきなのでしょうか? 今回の勉強会では自然言語処理・人工知能分野のエキスパートである静岡大学の狩野先生をお招きし、具体的な研究事例の紹介から経済安全保障における活用の可能性まで、幅広く解説していただきました。また、株式会社FRONTEO取締役山本麻理からは、KIBIT Seizu Analysis(キビット セイズ アナリシス)によるサプライチェーン解析ソリューションとして「先端工作機械の中国流出」について解説しました。

静岡大学 情報学部 行動情報学科 准教授

狩野 芳伸

2001年東京大学理学部物理学科卒、2003年東京大学大学院情報理工学系研究科コンピュータ科学専攻修士課程修了、2007年同博士後期課程満期退学、博士(情報理工学)(東京大学、2011年)。同特任研究員、JSTさきがけ研究者等を経て、2014年に静岡大学学術院情報学領域 准教授(現在に至る)。人工知能学会代議員、情報処理学会・言語処理学会各正会員。大学院より一貫して自然言語処理の研究に従事。より人間に近い自然言語処理モデルの構築と、対話・医療・法律・政治など言語処理の応用に興味をもつ。

株式会社FRONTEO 取締役/AIソリューション事業統轄 兼 社長室長

山本 麻理

広告代理店に入社後、リスクマネジメント会社に在籍。メンタルヘルスケア事業を立上げ、事業計画、商品開発、マーケティング、営業戦略を実行し業界トップシェアへと導く。2014年に同社取締役に就任し、2017年に東証一部上場を実現。2018年12月より株式会社FRONTEOに参画、2020年取締役に就任しAIソリューション事業全域を管掌・指揮。

♦「超ものまね」としては優秀だが、実際は次の単語を予測してつないでいるだけ

生成AIと並んでよく語られるのが、自然言語処理というフレーズです。 今回の勉強会は、その意味を紐解くことから始まりました。

狩野氏(以下敬称略):自然言語処理とは、日本語や英語などの自然言語をコンピュータで処理する工学分野のことです。初期の自然言語処理は、単語や品詞、主語述語などの言語学的情報を手作業でコンピュータに学習させていました。ただ、これでは膨大な時間と労力がかかります。そこで、20年ほど前から機械学習が採用され、正解を人間が作ってそのパターンを機械に学ばせる手法が主流になりました。生成AIはここ3年ほどで登場した新しい手法ですが、仕組み自体は既存の機械学習を利用しています。

機械学習というと難しく感じますが、私は「超ものまね」と言い換えて説明しています。人間が沢山お手本(データ)を用意すると、コンピュータがそのものまねをしてくれる。例えば「これは猫です」という正解の画像を大量に見せたら、コンピュータは猫の特徴を学習し、初めて見る画像からも猫を判別できようになります。お手本が多ければ多いほど性能は上がりますが、全く見たことがないデータには対応できません。お手本があるので、私たちはこれを教師付き機械学習と呼んでいます。

自然言語処理においてもポイントは「正解付きのデータをどれだけ大量に用意できるか」ですが、画像ほど簡単ではありません。

狩野:主語がどれなのかという正解を与えるのは人間であり、その作業に膨大な時間とコストがかかるからです。そこで考えられたのが、「伏字を予測させる」方法。世の中にあふれているウィキペディアなどの文章にはそれ自体に正解がありませんが、例えば、“You【?】goodbye and I say hello”という単語当てクイズなら、【say】という正解を作ることができます。これをコンピュータに1億回、1兆回、1京回というレベルでやらせたら、語彙、構文、意味、文脈などを理解して単語を予測できるようになるのではないか? と考えたわけです。この取り組みの結果が現在の大規模言語モデルと呼ばれるもので、実際のところ単語や構文、意味的なところまでかなりの精度が出ています。つまり、次の単語を予想させ続ければ文章を生成することができるということ。逆の言い方をすれば、今の生成AIは「次の単語をつないでいるだけの単純な仕組み」にすぎないのです。

世界中を驚かせたChatGPTも大規模言語モデルの手法の一つですが、狩野先生は「従来の生成AIとは大きく異なっている」点を指摘しました。

狩野:それまでの生成AIには、事実とは異なる内容や有害性のある文章を生成しかねない課題がありました。また、指示の内容とはかけ離れた応答をすることも珍しくなかったのです。そこで、OpenAI社はそれまでの言語モデルに、人の手を借りた強化学習(Instruct GPT)を追加し、より人間に好まれる出力を生成するようにしました。その結果、信頼性が向上し、出力のバイアスや有害性も軽減されたのです。その性能向上には目を見張るものがありますが、私は現在の生成AIを「超・集合知」「超・重ね合わせ」と捉えています。沢山のことを知っていてそれらを組み合わせることができますが、人間のように筋道を立てて推論しているわけではないのではないかと考えています。そのため論理や人間関係、複雑な状況把握といった課題が、そのままではより不得手な可能性があります。「生成」ですので、用途としては下書きやブレストが向いており、事実と異なる内容を生成する可能性があるため出力は必ず人間がチェックすべきと考えます。

♦研究を通じて見えてきた“生成AIの限界”

次に紹介したのは狩野先生の研究内容。ここから、自然言語処理で何ができるかが見えてきます。

狩野:私は長らく慶應義塾大学病院と協力し、自然言語処理による精神疾患(うつ病や双極性障害などの5大疾患)の自動診断システム構築を試みています。その内容は、話し言葉と書き言葉の両面から精神疾患を予測するというもの。話し言葉は患者と臨床心理士の録音会話(約1000時間)から、書き言葉は患者が使っているSNS投稿の書き込みから、精神疾患の種類を予測します。自然言語処理は書き言葉を対象にすることが多く、話し言葉の分析は難しいのですが、音響や単語レベルで特徴を拾い上げ、学習を継続。今のところ、各疾患の分類で8割程度の性能を得ています。それでも、会話全体のデータ量は学習に十分とは言えません。一方でSNSを用いたテキストデータの解析では大規模なデータが収集できます。約3千万件の投稿を分析した結果、こちらも8割ほどの正確さである種のユーザグループを分類することができました。前者は秘匿性の高い個人情報で外部に送信できないこと、また未知の明示的でない特徴をつかもうとしていることから、生成AIを直接適用するには向いていない課題です。

狩野先生が取り組んでいるもう一つの研究は、人工知能ならぬ人狼知能。嘘を見破る有名な会話ゲーム「人狼ゲーム」を自動プレイするAIモデルを開発しています。

狩野:囲碁や将棋などはプレーヤー間で情報が完全に公開されているゲームですが、人狼ゲームでは情報が隠されており、自分が得た情報が真実か嘘か分かりません。つまり、他のプレーヤーの意図を文脈から推測する必要があるわけです。また、相手とコミュニケーションを取って信頼を得る必要があり、人狼の自動プレーヤー構築は難易度の高い課題と言えます。毎年開催している「人狼知能大会」において、今年は生成AIを利用したモデルが主流になりました。結果、文章生成の能力は昨年までより格段に向上しており、一文を見ただけでは人間の文章と見分けが付かないほどです。一方で、生成AIの新たな課題も見えてきました。人狼ゲームでは自分が嘘つきの時、「Aさんは私を嘘つきだと思っている」「Bさんは私を嘘つきだと思っていない」「でもBさんは『Aさんが私を嘘つきだと思っている』に違いない」という、反射的な関係が大量に出てきます。生成AIが単体でこのような関係性をきちんと扱えるかどうかは、今後の研究課題です。

♦“嘘かもしれない”自動生成物にどう対処すべきか

さらに注目すべき研究テーマは、「SNSにおける欺瞞とその広がりの自動検出・推測と予防介入」。その内容は経済安全保障にもつながる深いものでした。

狩野:この研究はSNS上で発信されるフェイクニュースや偽情報をいち早く察知し、拡散を防止しようというものです。SNS上の情報が正しいかどうかは、発信した本人にしか分かりません。そこで、私たちは同じ人の発言に矛盾がないかに注目しました。もし矛盾していたら、発言のどちらかは嘘または発信情報の変化の表れで、そこには何かしらの“良くない”ことが含まれている可能性があると考えるのです。この検出をすべてのSNS投稿に対して行えば、特定意見の出どころや複数意見の矛盾点など、様々なことが見えてきます。つまりフェイクニュースの自動検出によって、インターネット上でどのように世論が形成されるのか、推測することができる可能性があります。この分野の既存の研究は単語の統計しか見ていないことが多いですが、私たちの研究では文章ペアの関係認識(矛盾・含意・中立)と影響力予測をミクロで計算し、全体を時系列で捉えたいと考えています。

そこで気になるのは、どういう人がどのような発信をすると、それを受信したどういう人がどのように変わるのか。(悪の)インフルエンサーと(欺瞞に)流される大衆という構図です。

狩野:それを調べるため、私たちは旧ツイッターのアクティブユーザー数千人に対し、大規模なクラウドソーシング調査を実施しました。性別・年齢・居住地・職業・学歴などの基本情報に加え、支持政党や支持政策などの政治的属性、性格に現れる心理的属性、特定の問題に対する賛否など、多岐にわたる質問を行ったのです。その上でそうした特徴を発信内容から推測できないか試みています。分析が進めば、「こういうツイートをしている人にはこういう属性がある」ことが見えてくるでしょう。またどういうツイートがバズりやすい傾向にあるかが分かれば、欺瞞だと思われる発信に対して自動的に介入し、到達力の高い形で訂正情報を発信することもできます。また、「どのようなツイートを発信すれば意見が変わるのか」を推測することと合わせ、欺瞞に対する予防的介入ができればと思います。私たちは将来この研究結果を公開した上で一般の方々がツールとして活用できる形にし、欺瞞に流されないための助けになればと考えています。

SNSの全アカウントに対する自動分析が可能ならば、この研究を経済安全保障の情報戦に活用することはできないでしょうか。自然言語処理、生成AI、検索の組み合わせに、経済面でのプラス効果を期待したくなります。

狩野:生成AIが登場し、誰もが簡単に高品質な自動生成テキストや音声・動画を作れる時代になりました。最近、岸田首相のフェイク動画がニュースになりましたが、今後はインターネット上に“嘘かもしれない”自動生成物が溢れ返ることになるでしょう。情報の出どころ追跡には、今まで以上に高度な技術が求められるはずです。サプライチェーンの情報を調べる場合なら、対象となる企業や組織の情報を可能な限りテキストデータで入手することが前提になります。生成AIを活用した調査・分析サービスであれば、論文やSNSなどの公開情報を組み合わせて表からは見えない関連性を明らかにし、その結果を分かりやすい文章で伝えることができるでしょう。自然言語処理の研究者としては、生成AIに論理や複雑な事物・人間関係を理解できる能力を付加したいですね。そのことが次のブレークスルーにつながると思いますが、そのアプローチとしてより人間に近いAIモデルを開発できないかと考えています。

♦欧米に輸出した自社製品が中国の核開発に使われている?

FRONTEOの山本は「先端工作機械の中国流出」をテーマに、当社が開発した経済安全保障対策ネットワーク解析システム「KIBIT Seizu Analysis」の活用例を紹介しました。

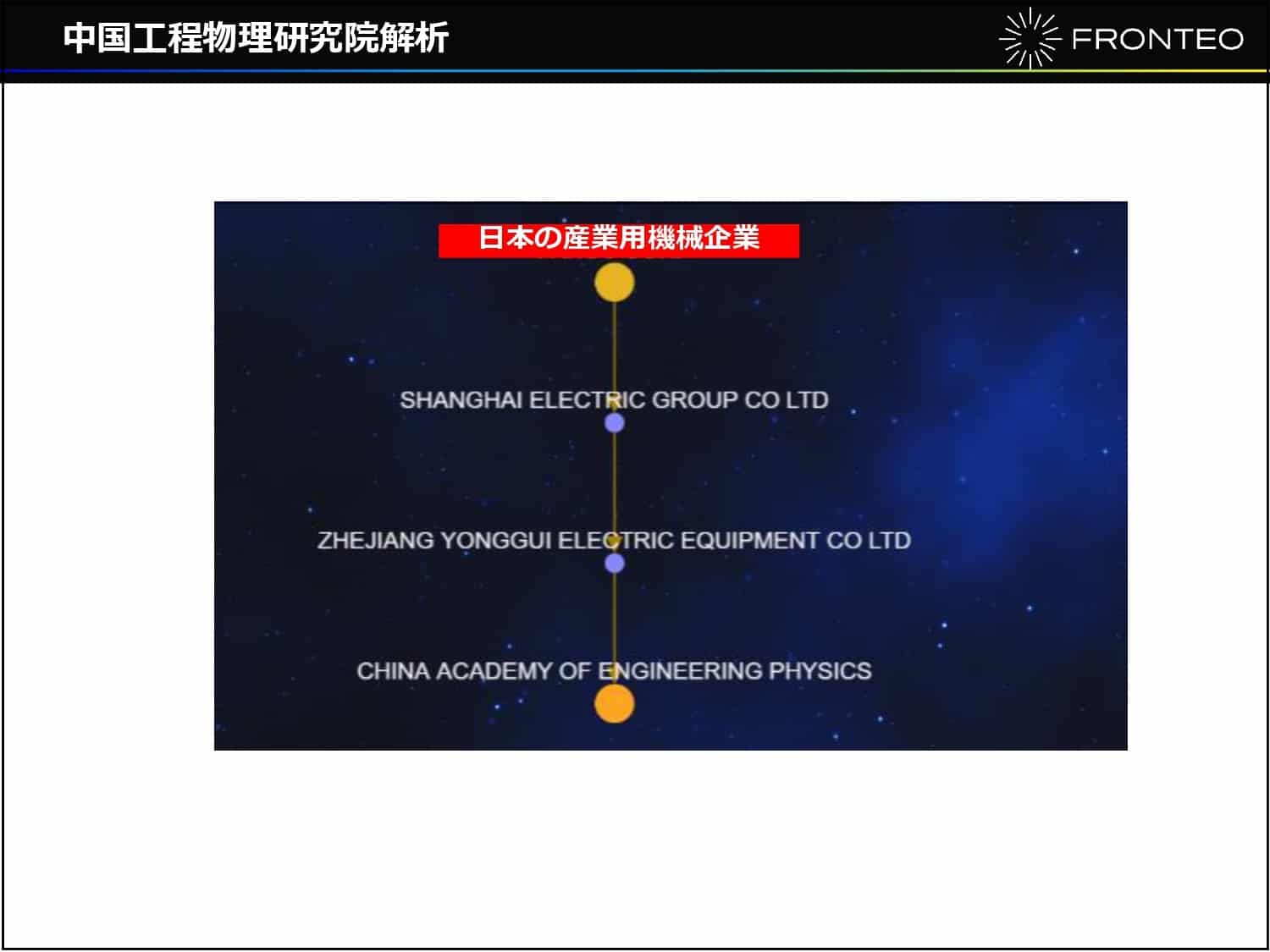

山本:2023年11月8日付の日本経済新聞朝刊の1面に、「日米欧が規制の工作機械63件、中国の核開発に転用か」という記事が掲載されました。2022年以降、日米欧諸国の先端技術が少なくとも140件、核兵器の開発を担う中国工程物理研究院(CAEP)に流出した可能性があると報道されたのです。同組織は米国のエンティティリストにも掲載されている輸出規制対象。流出した中でも工作機械は最も多く、63例にも及びました。今回は、彼らがどういうルートで製品を入手したのかをスクリーニングしてみましょう。Tier1での直接取引はなかったものの、Tier2では米国企業5社とのつながりが明らかになりました。図はその一例です。

一方、日本の産業用機械企業ではTier3で2社とのつながりが抽出されました。社名は出せませんが、この分野の大手企業です。もう少し掘り下げて調査する必要はありますが、製品が核兵器開発に転用されたとなると、輸出後の経緯が気になるところ。同様の懸念をお持ちの企業様は、今一度自社のサプライチェーンを確認していただきたいと思います。